+1500 tilfredse AI kunder

GENERATIV AI GUIDE 📖

Bliv klogere på generativ AI og forstå hypen

I denne guide starter vi med at se nærmere på hvad generative AI (generativ kunstig intelligens) er for en størrelse og de “principper” der ligger bag. Herefter dykker vi ned i mere konkrete anvendelsesmuligheder. Det gælder bl.a. avanceret billed- og tekstgenerering. Vi kommer også ind på forskellige trends. Og snakker til slut om hvordan det kommercielle potentiale ser ud.

Undervejs zoomer vi ind på nogle af de vigtige overvejelser, der gør sig gældende, når vi snakker generativ AI. Det gælder både etik, bias og generelt ansvarlig brug af generativ AI. Målet er at du efter at have læst guiden, har en nogenlunde fortåelse af hvilken størrelse generativ AI er.

Hvis du vil være endnu klogere og arbejde videre med generativ AI. Så se nærmere på de forskellige AI kurser, som vi tilbyder. På de flesker kurser er generativ AI en central del af læringen.

Med denne lidt længere indledning. Lad os komme i gang!

Indholdsfortegnelse

Er du interesseret i at lære mere om generativ AI? Så kan et AI kursus være noget for dig.

Introduktion til generativ AI

Hvad er generativ AI? The basics

Når der snakkes eller skrives om Generativ AI så handler det om avanceret AI, der kan “generere” (heraf generativ) ny data (eksempelvis tekst, billeder, lyd og video).

Hvor klassisk AI (der har eksisteret i årtier) har fokuseret på at analysere data. Det kunne være Facebook, der bruger AI til at analysere hvilken reklame du skal eksponeres for på baggrund af de milliarder af datapunkter de har fra dig og andre brugere.

Så skaber generativ AI altså noget nyt, der ikke findes i forvejen, det vil også sige, at når du ser et AI genereret billede. Så findes den person eller det dyr du ser ikke i virkeligheden.

De mest kendte eksempler når vi snakker generativ AI er nok Midjourney (billedgenerering), ChatGPT (tekster og kode), og Runway (videogenerering).

Der mange andre leverandører og indenfor musik og lyd sker der også en masse interessante ting f.eks. liveoversættelse til andre sprog, hvor det stadig er din stemme, der bruges.

Uden at gå for meget ind i det tekniske, så er det maskiner, der kan lære mønstre at kende, eksempelvis ved at være trænet på millioner af billeder. På baggrund af denne træning vil de efterhånden kunne genere nye “data”. Så ved at have set f.eks. 100.000 billeder af en tiger, så lærer de hvad der kendetegner en tiger, og kan til sidst så “skabe” en “ny” tiger, der ikke findes i forvejen.

Historie og udviklingen af generativ AI

Generativ AI har eksisteret i årtier, men er først for nylig blevet avanceret nok til praktiske anvendelser. Dette skyldes nogle teknologiske fremskridt både ift. de algoritmer der benyttes, samt det hardware, der er idag er til rådighed.

De seneste par år er det gået virkelig stærkt. Det mest banebrydende eksempel var nok da OpenAI lancerede deres model GPT-3. Der gjorde det muligt at få tekst svar, der gav mening. Hvilket var et kæmpe skridt ift. hvad der tidligere var muligt.

Idag er der kommet mange nyere og langt bedre modeller og alle de store techselskaber arbejder på deres egne sprogmodeller og billedetjenester. Det gælder alt fra Google, Amazon, Meta, X mv. Og udviklingen kommer umiddelbart ikke til at gå langsommere. Da der investeres mange milliarder af dollars fra alle disse.

Grundlæggende principper i generativ AI

Hvordan generativ AI fungerer

Generativ AI bygger typisk på dybe neurale netværk, der trænes på meget store datasæt. Du behøver ikke at forstå hvad dybe neurale netværk er. Det du skal vide er, at “systemet” kan lære, at genkende ekstremt komplekse sammenhænge og mønstre.

Derfor kan disse generativ AI modeller efter de er færdig trænet generere nyt indhold og data fra bunden. Hvis man sammenligner de output man får fra modellerne, så vil man finde sammenhæng imellem de data de er trænet på.

Der findes forskellige modeller (arkitekturer), der gode til forskellige områder. Nogle er eksempelvis gode til billeder og andre til tekst.

Typer af generativ AI

Dette er for de færreste (os nørder 😊) så hop evt. til næste afsnit.

Men her er nogle af de mest populære modeller og deres styrker:

- GANs: Består af 2 modeller der træner hinanden. God til billeder. Giver ofte meget realistic udseende resultater.

- VAEs: Autoencoder der først koder og så genskaber data. Anvendes bredt til alt fra tekst til molekyledannelse. Kan effektivisere arbejdsgange ved at foreslå nye datapunkter.

- Diffusionsmodeller: Introducerer “støj” som så raffineres til billeder. Meget realistisk på specielt ansigter og fine detaljer. Kræver dog mange sampling steps under genereringen.

- Autoregressive som GPT modellerne fra OpenAI: Generer tekst, kode og lyd trinvis. Avanceret sprogforståelse, men ikke så gode til semantisk sammenhæng på længere tekst.

Datagrundlag og modeltræning

Succes med generativ AI afhænger i høj grad af mængden af højkvalitetsdata et system trænes på. Jo større datasæt med god diversitet, des bedre resultater. Dette er gældende i alle AI projekter. Så hvis vi tager billeder som et eksempel, så er det vigtigt, at der er mange forskellige katteracer i forskellige farver i de datasæt modellen trænes på. Ellers vil alle katte du beder den lave se stort set ens ud.

Når du så har styr på dataen, så kræver det ekstremme mængder “computerkraft” at træne modellen. De nyeste modeller er trænet på titusindvis af GPU’er og TPU’er (der typisk ligger i et eller flere datacentre).

Og de nye modeller der arbejdes på bliver kun dyrerere og dyrere, hvorfor det som startup bliver sværere og sværere at komme ind på markedet. De nye modeller ChatGPT og Google arbejder på snakkes der om koster +10 mia. $ at udvikle alene i udgifter til datacentre.

Anvendelser af generativ AI

Kunst, billeder og kreativitet

Når det gælder kunst, så er det generativ AI virkelig et af de områder, der kan skabe uenigheder blandt både kunstkritikere og dem der laver kunsten. For kan man kalde det kunst, hvis det er en maskine og ikke en person, der har kreeret værket? Dette vil jeg ikke gøre mig til dommer over.

Men det er i hvert fald muligt at skabe nye originale billeder, der ikke findes andre steder. Et af de områder, der virkelig har taget generativ AI til sig er reklame- og designbranchen. Her gør de nye billedemodeller det muligt at lave langt flere designs hurtigere end det tidligere har været muligt. Ligesom en professionel udseende reklame, der tidligere tog flere uger at udvikle kan laves på timer.

Tekstgenerering og naturlig sprogforståelse

Dette er området som flest “normale” personer har stiftet bekendtskab med f.eks. ChatGPT.

Når du benytter ChatGPT, så chatter du med en stor sprogmodel (LLMs på engelsk) det kunne f.eks. være GPT-4o. Her kan du chatte / skrive prompt og få svar på spørgsmål uden at skulle kunne kode, og have en normal dialog uden, der er et menneske involveret.

Fordi kvaliteten er blevet markant bedre med de nye modeller, har det også gjort, at der er flere steder, at modellerne kan bruges. I dag benytter flere og flere virksomheder chatbots til alt fra kundeservice til teksforfatning og ide generering mv.

Hvis du selv har leget lidt rundt i ChatGPT, men gerne vil udnytte mere af potentialet, så kig nærmere på om der ikke kunne være et AI kursus, der kunne passe dig.

Musik og lydproduktion

Dette er nok det mest oversete område inden for generativ AI. Men også her går udviklingen hurtigt. Systemer kan både komponere genrespecifikke melodier, konvertere audio til tekst og omvendt, ligesom det er muligt at isolere udvalgte stemmer ud fra en lydfil, hvor der er mange stemmer på.

Dette betyder, at man i dag kan redigere f.eks. en podcast langt hurtigere end tidligere og en dårlig optagelse kan man få til at lyde helt hæderlig. Derudover vil taleassistenter kun vende endnu større indpas over de næste år. Vi er dog stadig lidt efter i Danmark, når vi sammenligner os med USA. Simpelthen fordi, at der er trænet på færre danske stemmer end engelske/amerikanske.

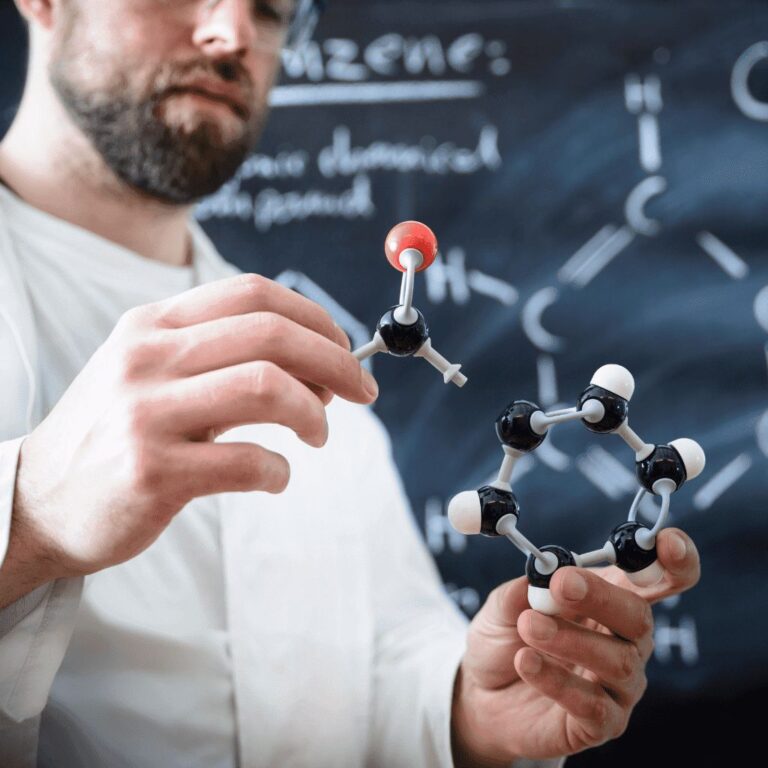

Generering af videnskabelige data

Inden for den grundvidenskabelige forskning bruges generative modeller til at eksempelvis generere molekyler med bestemte egenskaber, simulere fysiske fænomener, opstille hypoteser mv.

Dette kan være med til at accelerere opdagelser og eksperimenter. Dog kræver det solid forståelse for modellernes begrænsninger og systematisk validering af output.

Der findes efterhånden flere og flere specialtrænede modeller, der er gode inden for nicher af videnskaben. Det gælder bl.a. proteinfoldning (jeg ved ikke engang hvad det præcis er), men det er ihverfald uhyre tidskrævende. Og en enkelt forsker kan nemt bruge måneder eller år, på at løse et “problem”. Indenfor netop dette felt, har Google lavet en specialiseret model (AlphaFold). Denne model kan udføre opgaver på en brøkdel af tiden, i mange tilfælde snakker vi faktor 100 eller faktor 1000 ift. effektivitet.

Ansvarlighed og pålidelighed indenfor generativ AI

Bias og fairness

Skelettet i AI modeller er dataen. Ikke bogstaveligtalt, men man kan sige, at modellen ikke kan løfte mere en skelettet/ dataen kan bære. Derfor er disse data alfa og omega for gode resultater. Men selvom dataene er korrekte, kan der stadig opstå problemer.

Et af de eksempler, der oftest tages frem, er omkring kriminalitet. Her har der været flere sager, hvor bestemte “persontyper” er blevet stoppet på baggrund af AI. I sig selv var dataen ikke forkert, men fordi disse bestemte personer blev stoppet oftere, førte det til en ondcirkel, hvor dataen til sidst blev skæve, fordi disse personer blev noteret som syndere oftere, netop fordi de blev stoppet oftere. Det blev lidt kompliceret, håber det giver mening 😊

Disse ting kan man justere til i både data, træningsproces, måden man instruerer modellen mv. men det kan være svært at styre modellerne, når de selv for udviklerne kan være lidt af en blackbox.

Derfor er man nødt til at teste og afprøve modeller meget nøje før man bare ruller dem ud.

Sikkerhed og privatliv

Deepfakes er nok det første, der falder folk ind, når vi snakker sikkerhed. Det kan både være billeder og videoer, der manipuleres, så det ligner at personen foretager sig noget, der ikke er sket i virkeligheden. Men der har også været eksempler på stemmer, der er kopieret, så man har kunne snyde personer over telefonen. Derfor kan det være, at vi i fremtiden er nødt til at have et saveword som man kan spørge indtil, når man snakker med familie eller venner, der har brug for penge eller siger man skal gøre noget, der lyder mærkeligt.

Derfor arbejdes der også på forskellige løsninger, blandt de mest fremtrædende har Google kig på en vandmærkningsordning, når det gælder billeder.

På den længere bane er min vurdering at det nok er autonome AI agenter, som vi giver adgang til stemmer, mails mv., der kan skabe problemer med sikkerheden.

Miljøpåvirkning og bæredygtighed

Det er eksremt krævende at træne de nye store modeller, og de slider markant på både hardware har et enormt energiforbrug. Det kræver mange tons CO2 at udvikle de nye store modeller.

Præcis hvor meget det kræver både at udvikle og benytte de forskellige modeller er svært at sige, da de forskellige firmaer holder kortene ekstrem tæt på kroppen.

Så der skal gøres noget. Dette går fra chips over software til genbrug af modelparametre.

Men da stort energiforbrug også er = store udgifter, så arbejder både chipsproducenter og softwareudviklere på nye metoder, der meget muligt også kan blive en konkurrence fordel.

Konkret og til den mere tekniske side, så arbejdes der bl.a. på mere energieffektive tensor processorer, carbon-tracking, samt initiativer som machine learning model zoos til at dele parametre.

“Hvis du ønsker at kunne udnytte de muligheder generativ AI giver, så se nærmere på om vi ikke har et AI kursus, der passer dig eller din virksomhed”

Hvad bringer fremtiden når det gælder generativ AI?

Seneste fremskridt inden for generativ AI

Siden du læser med her, så har du nok på fornemmelsen at tingene går stærkt. Her er nogle af de områder vi vurderer vil være i fokus de næste år.

- Multimodal models der kombinerer tekst, billede, lyd, video i samme system

- 3D-generering og Virtual/Augmented Reality

- Specialiserede domænemodeller inden for f.eks. kemi, biologi, engineering

- Hardware-effektivisering via dedikerede AI chips og quantum computing

Men kigger vi endnu mere generelt, så vurderer vi at meget snart vil være umuligt at identificere om billeder, tekster og videoer er AI genereret.

Fremtidige udsigter og potentielle anvendelser

Der er ikke kun enkelte brancher, der vil blive ramt. Alle brancher og typer jobs vil blive påvirket i en eller anden grad, spørgsmålet er kun hvornår og i hvor høj grad. F.eks. sker der i øjeblikket ekstreme fremskridt når det gælder kodning, hvorfor at langt det meste kode der skrives fremover vil blive genereret af AI.

Samtidig arbejdes der på at gøre teknologien mere robust, pålidelig og tilgængelig via open source modeller og rammeværker der nemt kan tilpasses nye formål.

På den anden fløj findes de store tech giganter, der investerer mia. af dollars, som kan føre til at viden og magt samles på få hænder.

Hvor vi præcis ender er svært at sige. Men det går hurtigt. Også langt hurtigere end 99.99% af danskerne forstår.

Ressourcer og værktøjer for generativ AI

Populære frameworks og biblioteker

Hvis du er ny inden for generativ AI, så er det ikke her du skal starte. Så start istedet med en model du kan inteagere direkte med, som ChatGPT eller GoogleGemini.

Men hvis du er frisk på at tage næste step, så er det ofte med frameworks og biblioteker, at folk starter.

Her kan du arbejde videre på eksisterende generative modeller frem for at træne den fra bunden. Populære rammeværker er:

- TensorFlow: Meget udbredt machine learning platform

- PyTorch: Facebook’s åbne rammeværk til dyb læring

- HuggingFace: Bibliotek med utallige fortrænede modeller og pipelines

- Nvidia Riva: AI-værktøjer til tale og sprog

Disse gør det lettere at implementere og bygge ovenpå kendte modeller.

Læringsressourcer og kurser

Der findes efterhånden gode tutorials og guides på nettet om generativ AI. Mange af disse er gode, men både på engelsk og lavet af PHD’er, så det tekniske niveau er højt. Her kunne nævnes:

- Lex Fridmans Deep Learning kursus (MIT)

- Andrei Karpatys Deep Learning kursus (Stanford)

- Machine Learning Mastery artikler og kodeeksempler

Hvis du er på udkig efter et dansk mere praktisk orienteret kursus, så kan du trykke på den orange knap nedenfor og læse mere.

FAQS

Ofte stillede spørgsmål om generativ AI

Flere tech-giganter og AI labs udgiver efterhånden open source generative modeller, f.eks. Meta, Google, Anthropic, Baidu, mv. Konkrete steder du kan finde disse er bl.a. HuggingFace, TensorFlow Hub og PapersWithCode.

Dette er den mere tekniske tilgang, som er utrolig spændende men også for de få. For de fleste er prompt engineering mere relevant, hvor du lærer at interagere så effektivt som muligt med modeller som f.eks. ChatGPT, Claude, Gemini, Grok og Midjourney osv.

Det er svært at sige præcist. Men top modellerne fra Google, OpenAI mv. koster flere milliarder dollars. Og det tyder kun på, at de nye modeller, der er på vej, bliver endnu dyrere.

Så medmindre du er en enterprise med mange milliarder i omsætning, så vil det at træne en model, der skal kunne alting som de store tech virksomheder være usandsynligt. Og selv hvis man f.eks. var Arla eller en anden stor dansk virksomhed, så vil det sjældent give mening at prøve at konkurrere med de store selskaber i udlandet.

Man kan dog bygge ovenpå eksisterende open source-modeller, så man ikke skal bygge alt for bunden. Og her kan man stadig opleve værdi, hvis man træner modellen til at løse en nicheopgave, hvor man selv har unik data. Men at konkurrere med de store vil være et selvmål.

Man skal især være opmærksom på ophavsret ift. træningsdata og modellers output. Derudover er der lovmæssige rammer for beskyttelse mod misbrug af genereret indhold.

Generelt bør man søge juridisk assistance hvis generative modeller indgår i kommercielle produkter.

Eksperter forudser at generativ AI på sigt vil være blive mainstream vil have en kæmpe indflydelse på stort set alle typer af erhverv og jobs. F.eks. har chefen for Googles AI afdeling (Deepmind) udtalt, at han ikke finder det urealistisk at de fleste sygdomme kan være udryddet om 10 år pga. de spring AI tager i disse år.

Derudover snakker man om at generativ AI får “en krop”, efterhånden som der kommer flere robotter, der ikke bare er på en bilfabrik, men som normale mennesker kan have i deres hjem, der kan hjælpe med alt fra madlavning til støvsugning.

Når du først har adgang til en model, om det så er din egen eller eksempelvis ChatGPT, så handler det om bedst muligt at udnytte modellens potentiale. Det gør du ved at give den de instruktioner, der giver det ønskede output, dette kaldes prompt engineering, du kan læse vores guide om dette her.